توسعه سیستمهای هوش مصنوعی (AI) به سرعت در حال پیشرفت است و به همین دلیل شاهد حضور آن در بسیاری از صنایع، محصولات و خدمات هستیم. شکی نیست که هوش مصنوعی بر جوامع و زندگی ما تأثیر میگذارد. با توجه به این نفوذ و پیشرفت در توسعه و پذیرش سیستمهای هوش مصنوعی، اعتماد، رفتار و نگرانیهای اجتماعی باید مورد توجه قرار گیرد. سیستمهای هوش مصنوعی باید قابل اعتماد و شفاف باشند که این بحث همچنان هم ادامه دارد. ما با استناد به خلاصه ای از استانداردهای موجود، استانداردهای توسعه یافته، گزارشها، مقررات، ممیزی و پیشنهادات آزمایشی، دستورالعملهای صدور گواهینامه به خواننده کمک میکنیم تا با موضوع آشنا شود.

قابل اعتماد بودن هوش مصنوعی

در سالهای اخیر، بسیاری از سازمانها از دولتها، صنعت و دانشگاه درباره قابلیت اعتماد سیستمهای هوش مصنوعی بحث کردهاند. مقالات، پروپوزال ها و استانداردهای متعددی نیز منتشر شده است. این موضوع نشان میدهد که قابل اعتماد بودن سیستمهای هوش مصنوعی در سراسر جهان جدی گرفته شده است. هوش مصنوعی اتحادیه اروپا (EU) ACT1 اولین پیشنهاد جامع برای مقررات مربوط به خطرات توسعه و کاربرد هوش مصنوعی را منتشر کرد. با این حال، این تنها سند مرتبط در خصوص اعتماد به هوش مصنوعی نیست. تقریباً تعداد بیشماری نشریه در سالهای اخیر منتشر شدهاند که این موضوع را از زوایای مختلف مورد بحث قرار دادهاند.

قانون هوش مصنوعی در نسخه پیش نویس خود، تعریفی را ارائه میدهدکه عبارت است از:

سیستم هوش مصنوعی به نرمافزاری اطلاق میشود که با یک یا چند تکنیک توسعه یافته است و میتواند برای یک مجموعه معین از اهداف تعریف شده توسط انسان، خروجیهایی مانند محتوا، پیشبینیها، توصیهها را ایجاد میکند.

در مرحله بعد، باید تعریف کنیم که یک سیستم هوش مصنوعی قابل اعتماد چیست؟ بنابراین، ما به تعاریف ارائه شده توسط گروه تخصصی سطح بالا در زمینه هوش مصنوعی (AI HLEG) استناد میکنیم. این گروه تخصصی مستقل توسط کمیسیون اروپا (EC) در ژوئن 2018 راهاندازی شد.

آنها دستورالعملهای اخلاقی برای هوشمصنوعی قابل اعتماد را منتشر کردند که تعریف میکند که هوشمصنوعی قابل اعتماد باید دارای اجزای زیر باشد:

قانونی باشد و با تمام قوانین و مقررات قابل اجرا مطابقت داشته باشد

عاملیت و نظارت انسانی داشته باشد

استحکام فنی و ایمنی شامل انعطافپذیری در برابر حمله و امنیت

حفظ حریم خصوصی، کیفیت و یکپارچگی دادهها

قابلیت ردیابی، توضیح پذیری و ارتباط

اجتناب از سوگیری ناعادلانه، دسترسی و طراحی جهانی

رفاه اجتماعی و زیست محیطی

هوش مصنوعی هم از منظر فنی و هم از منظر اجتماعی باید قوی باشد، زیرا حتی با نیت خوب، سیستمهای هوش مصنوعی میتوانند آسیبهای غیرعمدی ایجاد کنند.

بنابراین، به عبارت دیگر، اعتماد به هوش مصنوعی را میتوان با ارزشهای انسان محور و عدالت که به اندازه کافی به این الزامات و ویژگیها پرداخته است را ایجاد کرد. با این حال، هیچگاه تعریف روشن و واضحی از الزامات کلیدی وجود ندارد.

با اتخاذ این اصول، توسعه دهندگان و سازمان ها می توانند اطمینان حاصل کنند که سیستم های هوش مصنوعی به شیوه ای مسئولانه، منصفانه و قابل اعتماد طراحی و مستقر شده اند که میتواند به ایجاد اعتماد و اطمینان در سیستمهای هوش مصنوعی کمک کند و به مخاطبین این اطمینان را بدهد که مزایایی را که آنها برایش طراحی شدهاند را ارائه میکنند و خطرات و تأثیرات منفی را که ممکن است بر افراد و جامعه داشته باشند را به حداقل میرساند.

قانون هوش مصنوعی اتحادیه اروپا

برجسته ترین پیشنهاد قانونی، قانون AI Act24 است که توسط EC پیشنهاد شده است. چارچوب نظارتی پیشنهادی در مورد هوش مصنوعی شامل موارد زیر است:

- حصول اطمینان از ایمنی و پایبندی به قوانین اتحادیه اروپا

- حصول اطمینان از تسهیل سرمایهگذاری و نوآوری در هوش مصنوعی

- تقویت حاکمیت و اجرای مؤثر قوانین موجود در خصوص اعمال سیستمهای هوش مصنوعی

- شناسایی و طبقه بندی بیومتریک اشخاص حقیقی

- شناسایی اشخاص حقیقی

چگونه میتوانیم به سیستمهای هوش مصنوعی اعتماد کنیم؟

اطمینان از اینکه سیستمهای هوش مصنوعی (AI) قابل اعتماد هستند، نیازمند رویکردی چند وجهی است که ذینفعان مختلفی از جمله توسعهدهندگان، کاربران، سیاستگذاران و تنظیمکنندههای هوش مصنوعی را در بر میگیرد. چند استراتژی کلیدی که میتواند به ایجاد اعتماد در سیستمهای هوش مصنوعی کمک کند عبارت است از:

طراحی اخلاق محور و مسئولانه:

سیستمهای هوش مصنوعی باید طوری طراحی و توسعه داده شوند که اخلاقی و مسئولانه عمل کنند از به حداقل رسیدن خطرات و به حداکثر رساندن منافع حاصل از آنها اطمینان شود.

قابلیت توضیح و شفافیت:

سیستمهای هوش مصنوعی باید به گونهای طراحی شوند که قابل توضیح و شفاف باشند، به طوری که کاربران بتوانند نحوه عملکرد سیستم و نحوه تصمیمگیری آنها را درک کنند.

مسئولیتپذیری و نظارت:

باید خطوط مسئولیت روشنی برای توسعه، استقرار و بهرهبرداری از سیستمهای هوش مصنوعی وجود داشته باشد که شامل حصول اطمینان از وجود مکانیسمهای مناسب برای نظارت و ممیزی سیستمهای هوش مصنوعی و وجود فرآیندهایی برای شناسایی و رسیدگی به هرگونه خطا یا سوگیریهایی است که ممکن است ایجاد شود.

استحکام و قابلیت اطمینان:

سیستمهای هوش مصنوعی باید به گونهای طراحی شوند که مستحکم و قابل اعتماد باشند که شامل حصول اطمینان از مقاوم بودن سیستم در برابر حملات سایبری، نقض داده ها و … است، و باید برنامه های اضطراری برای مقابله با هرگونه اختلال یا شکست وجود داشته باشد.

آموزش و آگاهی:

ایجاد اعتماد در سیستم های هوش مصنوعی مستلزم آموزش و آگاهی در بین کاربران و توسعه دهندگان است.

به طور خلاصه، ایجاد اعتماد در سیستمهای هوش مصنوعی نیازمند رویکردی جامع است که شامل طراحی اخلاق محور و مسئولانه، توضیحپذیری و شفافیت، مسئولیتپذیری و نظارت، استحکام و قابلیت اطمینان، و آموزش و آگاهی میباشد. با اتخاذ این استراتژیها، توسعهدهندگان و سازمانها میتوانند کمک کنند تا اطمینان حاصل شود که سیستمهای هوش مصنوعی به شیوهای مسئولانه و قابل اعتماد عمل میکنند و مزایایی را که برای ارائه طراحی شدهاند ارائه میکنند و در عین حال خطرات و اثرات منفی را که ممکن است بر افراد و جامعه داشته باشند به حداقل برسانند.

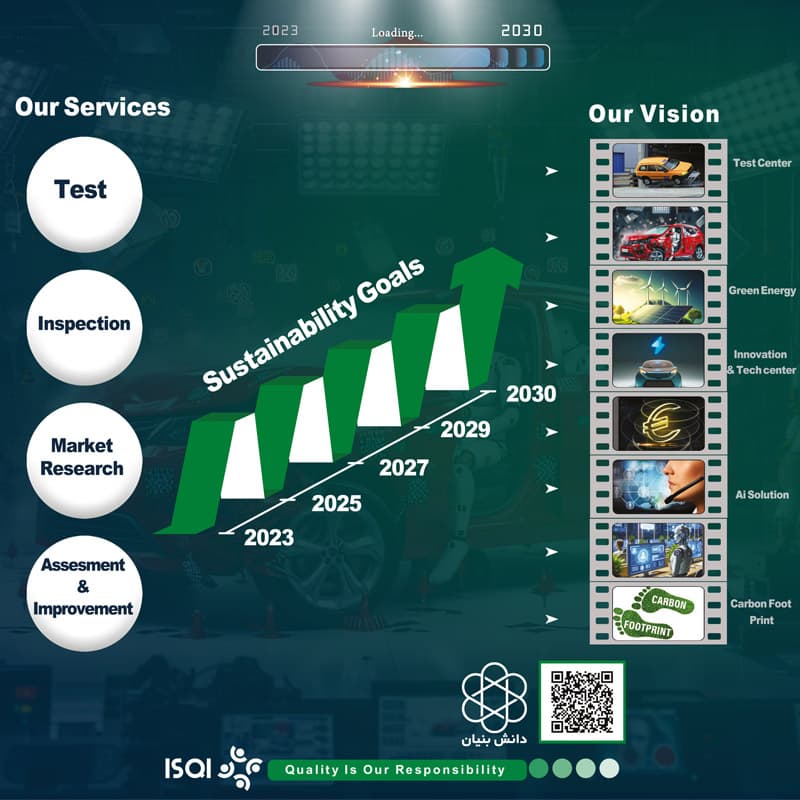

جمعبندی

به طور کلی درخصوص اعتماد به هوش مصنوعی، نحوه آزمایش یا تأیید آن، موضوعی نوظهور است. تحقیقات و قوانین در این حوزه درحال تکامل است. ما در این مقاله سعی کردیم گزارشی اجمالی در دنیای نوظهور هوش مصنوعی برای شما منتشر کنیم. Isqi شرکت پیشرو در خدمات بازرسی و صدور انواع گواهینامه (TIC) در تلاش است تا خود را مطابق نیاز جهان بروز کند.